L’omniprésence des réseaux dans notre quotidien masque souvent une fragilité insoupçonnée, une vulnérabilité silencieuse qui peut bouleverser des systèmes entiers en un instant. Dans cet univers complexe, chaque octet qui circule porte en lui la promesse d’une communication efficace, mais aussi le risque latent d’une faille dévastatrice. Que savons-nous vraiment des flux invisibles et des signaux qui orchestrent cette symphonie numérique ? La surveillance réseau ne se limite pas à une simple observation : elle incarne un art subtil d’anticipation où chaque donnée capturée peut faire la différence entre performance optimale et chaos imminent. En plongeant au cœur de ces mécanismes, on découvre un écosystème vivant, vecteur à la fois de sécurité renforcée et d’efficacité renouvelée, capable de transformer la complexité en clarté.

Un maillage fragile : la menace invisible qui rôde dans les réseaux

Un réseau informatique, ce n’est pas simplement un enchevêtrement de câbles et de terminaux. C’est une infrastructure vivante, soumise aux lois du trafic numérique et des comportements humains. Mais ce qui inquiète souvent, c’est l’imprévisible : la faille invisible, le flux anormal ou la surcharge furtive. Ces signaux faibles cachés peuvent compromettre non seulement la performance, mais aussi la confiance et la sécurité globale d’une organisation.

Comment dénouer ce tapis de flux ? Mécanismes et méthodes de la surveillance réseau

Au fond, surveiller un réseau revient à scruter un immense carrefour, où le moindre embouteillage ou véhicule suspect peut n’être perceptible qu’en regardant au bon moment et sous le bon angle. Plusieurs techniques émergent pour révéler ces instabilités.

Vérification périodique du statut : un contrôle rythmé sans fausse note

Cette méthode sonde régulièrement les états des composants – serveurs, routeurs, espaces disque – à intervalles minutés, souvent chaque minute. L’enjeu est de capter la disponibilité et la charge sans surcharger les appareils eux-mêmes. C’est un jeu d’équilibre délicat, car trop de vérifications deviennent une charge, trop peu risquent d’occulter des défaillances naissantes.

Journaux d’outils : l’horloge des événements

Chaque élément du réseau écrit son histoire en temps réel à travers des journaux. Ils consignent erreurs, alertes, et comportements remarquables avec un horodatage précis. En comparant ces écritures, on peut retracer l’enchaînement d’événements pour remonter à la source d’un problème, ou même prévoir son apparition.

Protocole SNMP, WMI, SSH : les communications discrètes entre acteurs du réseau

Les réseaux informatiques disposent d’une sorte de langage commun, notamment via le Simple Network Management Protocol (SNMP). Chaque appareil y joue un rôle d’informateur grâce à un agent intégré, relayant son état à un gestionnaire central. Sur les environnements Windows, l’Instrumentation de gestion Windows (WMI) offre un accès détaillé à l’état matériel et logiciel, alors que Secure Shell (SSH) permet aux administrateurs Linux/Unix d’interagir en toute sécurité avec les équipements à distance.

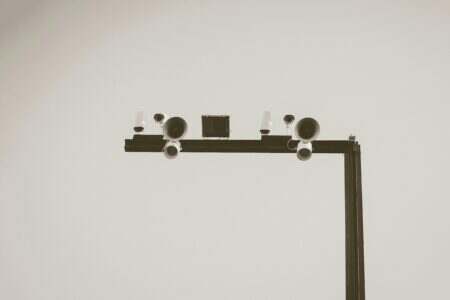

Reniflement de paquets et NetFlow : écouter les murmures du trafic

Il s’agit d’observer directement le flot de données, comme un vigile qui scrute le trafic à une intersection. Le reniflage de paquets intercepte et enregistre chaque paquet pour analyser ce qui circule, déceler un comportement malveillant ou anormal. NetFlow, quant à lui, capture les données en transit pour étudier la direction et la quantité du trafic, générant ainsi des alertes précises si le chemin des informations sort des normes admises.

Surveillance réseau : au cœur des enjeux de sécurité et de performance

Pourquoi tout ce déploiement ? Parce que le réseau est devenu la colonne vertébrale invisible des opérations quotidiennes, et sa défaillance coûte bien plus qu’un simple ralentissement. Le risque n’est pas simplement une panne : il s’agit d’attraper l’expérience du visiteur, d’éviter une violation de données, de prévenir une propagation malveillante. En réalité, la surveillance fournit un éclairage précieux pour mieux comprendre les flux, répartir la charge, et anticiper les incidents.

Elle aide aussi à mieux utiliser les ressources, en allégeant la pression sur le système et en évitant les interventions coûteuses. Par exemple, automatiser la surveillance permet aux équipes techniques de concentrer leurs efforts sur l’optimisation et la recherche plutôt que sur la réaction aux urgences.

Une transformation de la gouvernance des réseaux numériques

Un réseau sous surveillance constante n’est plus une boîte noire. Il devient un système vivant, pilotable en temps réel, capable d’alerter avant que la panne ou l’attaque ne frappe. Cette transformation modifie la manière dont les équipes gèrent la sécurité, notamment en intégrant des concepts comme la prévention des déplacements latéraux en cybersécurité, où l’objectif est de limiter la propagation d’une menace à travers le réseau.

Par ailleurs, à mesure que les technologies avancent, surveiller un réseau ne se limite plus à la détection, mais engage aussi une analyse avancée via des outils connectés à des systèmes de gestion centralisée (gestion centralisée) pour garantir une gouvernance cohérente et une réaction coordonnée.

Les nuances techniques à garder en tête : entre visibilité et charge ajoutée

Le défi majeur reste d’établir un équilibre prudent entre l’obtention d’informations précises et l’empreinte laissée par les méthodes de surveillance. Trop de contrôles provoquent du bruit, de la charge et parfois une forme de paralysie. A contrario, une surveillance trop sporadique risque de passer à côté d’alertes importantes.

Il faut aussi comprendre les différences entre les outils de sécurité : un pare-feu logiciel et matériel, par exemple, jouent des rôles complémentaires au sein de ce cadre, tout comme un serveur proxy et un pare-feu de filtrage de paquets ne remplissent pas les mêmes fonctions de contrôle et d’inspection des flux.

Vers une vigilance renforcée face aux enjeux éthiques et politiques

La collecte massive et constante des données de réseau pose aussi des questions sur la confidentialité et les libertés individuelles. Où placer la limite dans la surveillance sans tomber dans un contrôle excessif ? Quels protocoles garantir pour protéger les informations sensibles ?

Le futur laissera certainement une place importante à la transparence dans les dispositifs de supervision, mais aussi à des normes internationales pour encadrer l’usage des données réseau dans un cadre responsable. En attendant, cultiver cette compréhension technique aide à mieux envisager les bénéfices comme les risques, dans une quête aussi complexe que nécessaire pour garantir la robustesse des systèmes informatiques au cœur de notre société.

Enfin, penser le réseau, c’est aussi maîtriser son architecture matérielle, prenant en compte les basiques comme le commutateur Ethernet, essentiel pour orchestrer la circulation des données efficacement.

Surveillance réseau : plus qu’un simple outil technique, c’est finalement une habitude, un regard neuf porté sur tout ce qui circule derrière nos écrans.

Passionné par les nouvelles technologies depuis plus de 20 ans, j’exerce en tant qu’expert tech avec une spécialisation en développement et innovation. Toujours à la recherche de solutions performantes, je mets mon expérience au service de projets ambitieux.