Nous vivons dans un monde où chaque clic, chaque interaction, génère une vague incessante de données, un torrent que les infrastructures classiques peinent à contenir. Derrière ce flux numérique colossal, des géants invisibles s’affairent : les datacenters hyperscale. Ces mondes silencieux et tentaculaires défient nos conceptions traditionnelles du stockage et du traitement, transformant à jamais la manière dont les données prennent vie. Comment une infrastructure peut-elle s’étendre sans fin, tout en restant fluide, efficace, presque organique ? Entre puissance brute et finesse d’ingénierie, elle incarne une complexité souvent voilée, mais cruciale pour l’économie digitale. Plongez au cœur de cette révolution discrète, où la performance rencontre l’infiniment évolutif, et découvrez les secrets qui redéfinissent les règles du jeu informatique.

Une transformation majeure du stockage et du traitement des données

Les datacenters hyperscale incarnent aujourd’hui une rupture fondamentale dans la manière dont les données sont stockées et traitées. Contrairement aux infrastructures traditionnelles souvent limitées par leurs capacités physiques et énergétiques, ces installations sont conçues pour s’adapter rapidement à une croissance exponentielle des volumes d’informations. Ce saut technologique répond à une exigence simple mais difficile : pouvoir ajouter des ressources informatiques massives sans agrandir indéfiniment l’espace, ni augmenter la consommation énergétique ou la complexité de gestion.

Comment fonctionnent les datacenters hyperscale ?

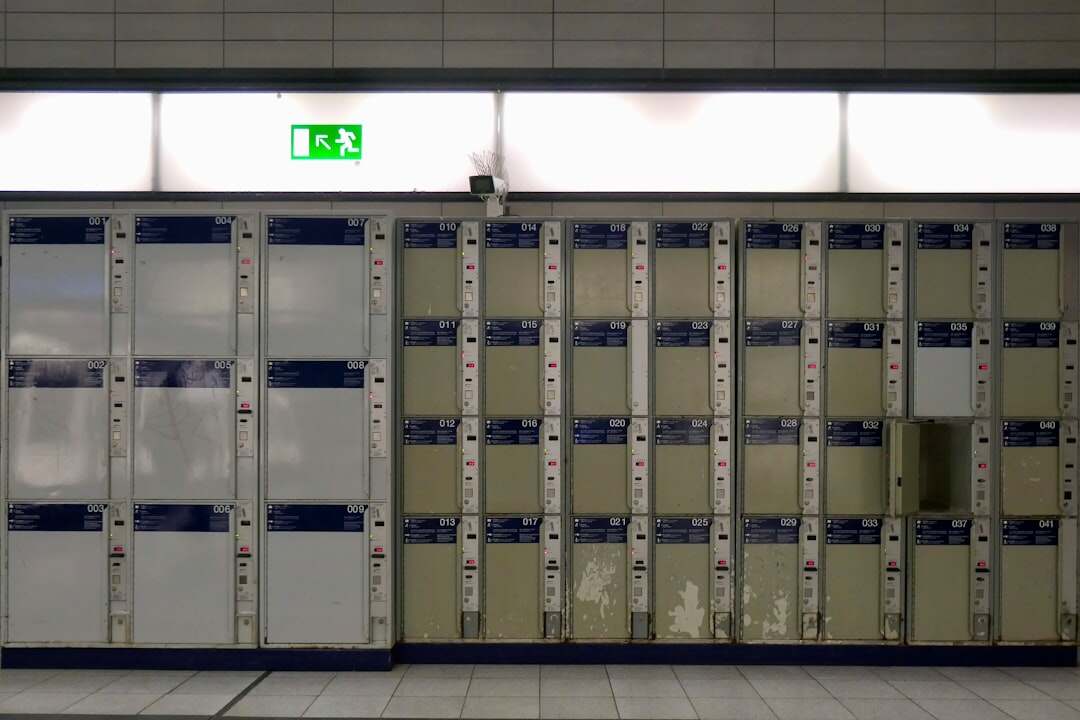

L’architecture hyperscale repose sur un réseau gigantesque de serveurs interconnectés, capables d’être déployés ou retirés en fonction des besoins en temps réel. Plutôt que de dépendre d’une seule machine puissante, cette approche fractionne la charge sur des milliers, voire des millions de dispositifs comparables, alignés horizontalement. L’idée est simple : additionner des composants standards pour obtenir une puissance totale considérable, tout en maintenant une souplesse d’adaptation. Les serveurs existent dans des racks élargis, conçus pour accepter facilement des modules variés – alimentation, stockage, processeurs – afin de s’ajuster finement aux besoins particuliers.

Un élément central orchestrant l’ensemble est l’équilibreur de charge. Il analyse en permanence la quantité de données à traiter, répartit la charge entre les serveurs disponibles, et ajoute ou retire des ressources lorsque la demande fluctue. Cette gestion automatisée évite à la fois le gaspillage d’énergie et la saturation des systèmes, un point qui devient non négligeable à échelle hyperscale.

Les enjeux derrière ce changement de paradigme

Avec l’explosion du Big Data et la montée du cloud computing, les organisations sont confrontées à des besoins massifs en termes de stockage et de calcul. Les datacenters hyperscale répondent à cette pression en offrant une capacité obtenue non pas par la puissance d’une seule machine, mais par l’agrégation d’un très grand nombre. Cette approche facilite également la mise en œuvre de politiques de sécurité plus robustes, simplifie les sauvegardes ainsi que la gestion des données, tout en évitant la prolifération inutile de copies.

La réduction des coûts opérationnels est notable, notamment grâce à des avancées dans le refroidissement des infrastructures. Ces installations concentrent la climatisation sur les zones les plus sollicitées et optimisent le flux d’air pour éviter les pertes thermiques. Elles récupèrent même la chaleur produite, un geste souvent méconnu mais qui illustre la volonté de concilier puissance informatique et exigences environnementales.

Une évolution qui redéfinit l’usage et la gestion des données

Le passage à l’hyperscale modifie la relation même des entreprises avec leurs capacités informatiques. Là où autrefois un projet d’analyse de données nécessitait une planification lourde et de longs délais, il devient aujourd’hui possible de lancer des traitements massifs en quelques instants. Le recours à des fournisseurs hyperscalers, comme Amazon ou Google, permet d’accéder à une infrastructure globale, standardisée et évolutive, donnant aux organisations une latitude sans précédent.

Pour les gestionnaires de données, cela signifie aussi un déplacement des compétences vers la maîtrise des plateformes cloud et de l’automatisation. L’automatisation hyperscale englobe non seulement la gestion dynamique des serveurs, mais aussi des fonctions avancées comme la cryptographie ou le rendu 3D, témoignant de la complexité croissante des charges de travail.

Ce qu’il faut observer dans l’avenir des datacenters hyperscale

Alors que la taille et la densité des datacenters hyperscale continuent de croître, jusqu’à couvrir plusieurs millions de pieds carrés, des interrogations relatives à la responsabilité sociétale et environnementale se posent. La consommation électrique, bien que mieux optimisée, reste colossale. La nécessité d’une sécurité renforcée, notamment vis-à-vis des systèmes de contrôle industriel connectés, doit être une priorité permanente.

En parallèle, le rôle des hyperscalers évolue, devenant non seulement fournisseurs d’infrastructures, mais aussi acteurs majeurs dans la gouvernance des données. Cette concentration des pouvoirs pose des questions quant à la souveraineté numérique et à la diversité face aux risques de monopole.

Au cœur de cette révolution technologique, les datacenters hyperscale s’imposent donc non seulement comme des leviers techniques, mais aussi comme des espaces où se jouent des enjeux politiques, éthiques, et écologiques. Leur développement invite à une vigilance continue, en gardant à l’esprit que derrière chaque enjeu technique, ce sont les futures modalités de notre société numérique qui s’écrivent.

Pour approfondir, la découverte du fonctionnement du data center éclaire aussi les fondements de cette nouvelle ère numérique.

Si une phrase semble trop parfaite, casse-la.

Si le ton devient trop lisse, rends-le plus humain.

Écris comme si tu parlais à voix basse à quelqu’un d’intelligent.

Passionné par les nouvelles technologies depuis plus de 20 ans, j’exerce en tant qu’expert tech avec une spécialisation en développement et innovation. Toujours à la recherche de solutions performantes, je mets mon expérience au service de projets ambitieux.