Internet est devenu un océan presque infini d’informations. Pourtant, cette richesse paradoxale reste souvent inorganisée, éclatée, difficile à exploiter pleinement. Au cœur de cette masse, une technique insidieuse, presque invisible, s’impose : le web scraping. Derrière ce terme technique se cache la capacité de dérober, d’extraire avec précision les morceaux pertinents disséminés sur des centaines, des milliers de pages web. Mais comment fonctionnent réellement ces outils qui promettent d’automatiser la capture de données à cette échelle ? Quels sont les mécanismes subtils qui transforment du contenu brut en information structurée et actionnable ? Cette exploration raconte plus qu’un simple processus technique, elle dévoile une manière de penser la donnée comme une matière première malléable, façonnable selon des applications infinies. En plongeant dans le fonctionnement des extracteurs, vous découvrirez une simple astuce qui révolutionne la manière dont les entreprises, les chercheurs ou même les passionnés brandissent le pouvoir insoupçonné du numérique.

La prolifération silencieuse du web scraping : un fil invisible au cœur du numérique

Le web scraping, tout en étant discret, s’est imposé comme une pratique majeure pour collecter de vastes volumes d’informations en ligne. Cette technique consiste à extraire automatiquement des données accessibles sur Internet, souvent à partir de sites publics. Le fait marquant, c’est que cette activité peut bouleverser la manière dont les entreprises analysent le marché, surveillent la concurrence, ou alimentent leurs bases de données.

Comment fonctionnent les outils d’extraction de données ? Une mécanique tissée de scripts et de requêtes

Au cœur du web scraping, il y a un programme, souvent appelé scraper ou bot, qui simule la navigation humaine sur un site web. Ce programme repère et récupère le contenu – texte, images, prix, avis – en parcourant le code HTML ou en interrogeant une API lorsque cela est possible. En réalité, il décompose la page comme un lecteur déchiffre un livre, mais avec une vitesse et une précision bien supérieures.

L’outil analyse ensuite la structure du site pour isoler les données pertinentes, les organiser en tableaux ou fichiers facilement exploitables. Cette opération peut être simple ou complexe, selon la nature du site, la protection mise en place (comme les CAPTCHA), ou les limites techniques imposées par le serveur.

Pourquoi le web scraping ne se résume pas à une simple collecte automatique

Le vrai poids du web scraping se ressent dans sa capacité à fournir un éclairage neuf sur un environnement commercial ou social. Par exemple, suivre en temps réel les variations de prix dans le secteur du commerce électronique permet de réagir aux stratégies des concurrents avec une précision difficile à atteindre autrement. De même, analyser les tendances des offres immobilières ou extraire des données financières publiques peut guider des décisions qui s’appuient sur des faits solides, mesurés et nombreux.

Ce qui compte ici, c’est l’accès rapide à des données massives, souvent non structurées au départ, capables de transformer un marché ou un secteur. En bref, le web scraping ouvre une fenêtre sur un monde d’informations autrement difficile d’accès, livrées de manière quasi instantanée.

Conséquences et limites : entre opportunités et défis

Si le web scraping présente un attrait évident, il entraîne aussi des défis et des risques. Sur le plan légal, le cadre de cette pratique reste flou dans plusieurs juridictions. Copier massivement un site sans accord peut se heurter aux droits d’auteur, ou aux conditions d’utilisation. Les entreprises victimes de scraping abusif subissent parfois une surcharge sur leurs serveurs, provoquant ralentissements ou indisponibilité.

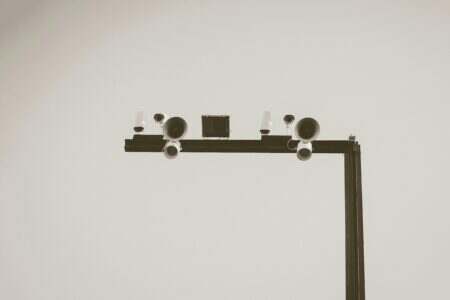

Par ailleurs, les sites web tentent de se protéger via des mesures techniques, comme les systèmes CAPTCHA, qui différencient humain et robot. Pour mieux comprendre ces mécanismes qui freinent le scraping, il est utile de connaître leur fonctionnement, ainsi que les méthodes déployées pour les contourner ou les respecter légitimement.

Un regard vers demain : évolutions technologiques et enjeux éthiques

L’évolution des outils d’extraction de données suit celle des technologies web et des capacités de calcul. Les bots deviennent plus sophistiqués, capables d’interagir avec des interfaces complexes, de traiter des données non structurées et d’apprendre à ignorer le bruit. En parallèle, l’intelligence artificielle ouvre la voie à une lecture plus fine, à des analyses prédictives nourries par ces données extraites.

Cependant, ce succès apparent soulève des questions éthiques et sociétales. La frontière entre collecte légitime et intrusion dans la vie privée s’estompe. L’accès aux données sensibles, voire la construction de bases client à partir de sites accessibles, pose un problème de consentement explicite. De plus, il faut surveiller l’usage de ces données, notamment leur exploitation dans les algorithmes de ciblage publicitaire ou décisionnels.

Les réglementations tentent de suivre, mais la rapidité des innovations complique leur mise en place efficace. D’où la nécessité d’une vigilance partagée, entre développeurs, entreprises et autorités, cherchant un fragile équilibre entre innovation technologique et respect des droits individuels.

Applications concrètes du web scraping : une diversité d’usages loin d’être anodine

Le web scraping prend des formes très variées, selon les secteurs et les besoins. La veille tarifaire en est une parmi les plus courantes : les entreprises collectent les prix affichés chez différents concurrents pour ajuster la leur. Cela ne se limite pas à suivre un chiffre brut, mais inclut l’analyse du contexte saisonnier, des promotions ou des ruptures de stock.

D’autres utilisent cette pratique pour étudier un marché dans le temps. En examinant l’offre disponible et ses fluctuations, il devient possible de prévoir des opportunités ou des risques. Par exemple, dans l’immobilier, suivre l’historique des ventes aide à définir des tarifs justes, favorisant la fluidité sans sacrifier les marges.

Le domaine financier tire aussi parti de ces données alternatives. Contrairement aux rapports classiques, l’extraction web permet d’obtenir rapidement des indicateurs issus de multiples sources, notamment via les dépôts publics comme ceux de la Securities and Exchange Commission (SEC). Agrégées et croisées, ces informations alimentent des modèles d’analyse plus fins, capables de détecter des tendances ou des signaux faibles.

Enfin, le web scraping intervient dans la génération de leads ou la surveillance de marque, en identifiant des prospects potentiels ou en débusquant toute information négative susceptible de nuire à une entreprise. Ce sont là des fonctions qui transforment le scraping en outil opérationnel au quotidien.

Sécurité opérationnelle et protection des données collectées

L’exploitation de ces données nécessite également un cadre sécuritaire solide. Par exemple, protéger les informations critiques et respecter les législations sur les données personnelles devient indispensable pour ne pas fragiliser l’entreprise qui scrappe. La maîtrise des risques passe par une compréhension approfondie des vecteurs d’attaque, comme expliqué dans cet article.

Par ailleurs, lors du scraping, il peut être nécessaire de résoudre des CAPTCHA, qui sont une forme courante d’obstacle aux scrapers. Savoir décrypter leur fonctionnement aide à comprendre où se situe la limite entre automatisation et intervention humaine, comme le détaille cette ressource ici.

Au-delà des techniques : considérer les défis de prospection et d’exploitation des données

Le web scraping ne garantit pas la réussite immédiate dans des domaines comme la prospection commerciale. En effet, le simple fait de disposer de listes et contacts ne suffit pas si la qualité des données ou la méthode d’approche est faible. Pour mieux comprendre ces écueils, il vaut la peine de se pencher sur les raisons pour lesquelles la prospection échoue parfois avant même de commencer, analysées finement dans cet éclairage développé ici.

Environnement et gestion des ressources : un angle inattendu du web scraping

Un dernier aspect, souvent oublié, concerne l’utilisation des données collectées dans des contextes inattendus, par exemple la protection agricole. Des informations prélevées sur des sites météorologiques ou agricoles peuvent être cruciales pour anticiper les risques de chaleur intense impactant les cultures, comme décrit dans cet article spécialisé. Cela illustre bien combien le web scraping peut s’intégrer à des domaines qui dépassent la sphère commerciale immédiate.

Si une phrase semble trop parfaite, casse-la.

Si le ton devient trop lisse, rends-le plus humain.

Écris comme si tu parlais à voix basse à quelqu’un d’intelligent.

Passionné par les nouvelles technologies depuis plus de 20 ans, j’exerce en tant qu’expert tech avec une spécialisation en développement et innovation. Toujours à la recherche de solutions performantes, je mets mon expérience au service de projets ambitieux.