La virtualisation des serveurs transforme en profondeur la manière dont les entreprises gèrent leurs infrastructures informatiques, jetant à bas les anciennes certitudes sur l’allocation des ressources. Sous une apparente simplicité, elle dissimule une complexité souvent sous-estimée : comment concilier économie et performance, liberté et contrôle, agilité et sécurité ? L’enjeu dépasse le simple remplacement de matériel par des machines virtuelles ; il touche à la substance même de l’efficacité opérationnelle. Dans ce paysage mouvant, chaque décision influe sur l’équilibre délicat entre potentiel inexploité et risques insidieux. Alors, comment véritablement optimiser ces ressources virtuelles tout en renforçant la robustesse des environnements ? Ce voyage nous invite à explorer les mécanismes silencieux, les stratégies affinées qui transforment la virtualisation en levier puissant, révélant ainsi un horizon où technologie et innovation se conjuguent pour façonner des infrastructures plus intelligentes et résilientes.

La complexité croissante des architectures physiques et ses limites

La multiplication des serveurs physiques dans les data centers est devenue un véritable casse-tête. Chaque machine accueille une application ou un service spécifique, souvent sous-utilisée, gaspillant ainsi une grande part des ressources disponibles. Cette fragmentation augmente le coût matériel, l’énergie consommée, ainsi que la maintenance. La virtualisation des serveurs s’impose alors comme une réponse pragmatique à ce défi.

Comprendre le fonctionnement de la virtualisation des serveurs

La virtualisation consiste à abstraire les ressources matérielles d’un serveur, pour créer plusieurs machines virtuelles (VM) indépendantes et isolées au sein d’un même équipement physique. Un hyperviseur, logiciel intermédiaire, distribue processeurs, mémoire, stockage et réseau entre ces VM, chacune pouvant exécuter son propre système d’exploitation et applications. Cette indépendance confère une flexibilité que les serveurs physiques ne peuvent offrir.

Pour mieux saisir, imaginez un immeuble où chaque appartement fonctionne indépendamment, partageant seulement les fondations et les installations communes. De la même manière, chaque VM cohabite sur la même machine physique, avec des ressources attribuées selon la demande.

Pourquoi la virtualisation change la donne

La consolidation des serveurs physiques réduit la dissipation de ressources. On évite les serveurs au ralenti, sous-exploités, coûteux à maintenir. Cela facilite aussi la gestion, car une VM peut être créée, modifiée, déplacée ou supprimée en quelques minutes, sans intervention hardware. Le déploiement devient plus fluide et adapté aux besoins précis. De plus, la virtualisation offre des mécanismes robustes pour isoler les environnements, diminuant les risques de propagation d’incidents d’une VM à une autre.

Suivre la performance et l’utilisation des ressources reste néanmoins nécessaire. Des outils spécialisés permettent de détecter rapidement une VM surdimensionnée, gaspillant du CPU ou de la mémoire, ou une VM sous-dimensionnée ne délivrant pas la performance attendue. Cette vigilance soutient une allocation raisonnée et évite la dérive des coûts.

Changer les pratiques, changer la gestion

Les entreprises doivent adapter leur gouvernance. La création anarchique de VM, sans vision claire, conduit à un « stock » de machines virtuelles inutilisées ou oubliées. La mise en place de systèmes en libre-service limitant la durée de vie des VMs encourage les utilisateurs à faire le tri régulièrement. Cela évite une inflation silencieuse des ressources consommées.

La standardisation grâce à des modèles préconfigurés garantit une allocation adaptée sans sollicitations excessives. Par exemple, une VM configurée systématiquement avec trop de processeurs ou de mémoire, se traduit à l’échelle par un gaspillage massif, inutile. Des menus intelligents orientent vers des options raisonnables, harmonisant les ressources allouées.

Le volet sécurité : un défi accru

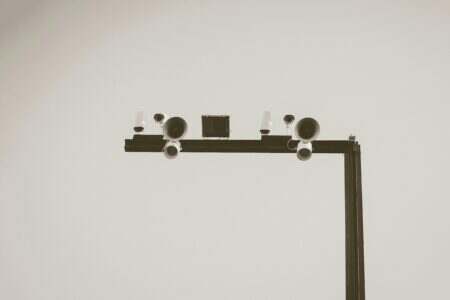

La centralisation des machines virtuelles sur un même hyperviseur altère la surface d’attaque. Si une plateforme de gestion tombe entre de mauvaises mains, l’ensemble des VMs hébergées est potentiellement à risque. La mise en place de contrôles d’accès précis, basés sur des groupes d’utilisateurs, et l’utilisation d’authentifications renforcées, comme la multifactorielle, deviennent incontournables.

Il ne faut pas perdre de vue que ces environnements sont des cibles privilégiées des attaques, surtout avec l’explosion du travail à distance. Les administrateurs peuvent se connecter via un VPN sécurisé avec une authentification avancée pour limiter l’exposition des interfaces de gestion. Cette couche supplémentaire fait la différence entre une exploitation maîtrisée et une faille catastrophique.

D’ailleurs, la virtualisation modifie aussi la manière de concevoir la sécurité réseau, un domaine qui s’appuie depuis longtemps sur des concepts comme le pare-feu périphérique ou le sandboxing. Ces protections doivent être pensées en incluant la virtualisation comme un nouveau maillon.

Sauvegarde et restauration spécifiques aux environnements virtualisés

Les techniques traditionnelles de sauvegarde basées sur des agents installés dans chaque serveur physique donnent rapidement leurs limites. Le volume de données transféré et la charge réseau peuvent devenir contraignants dans un environnement virtualisé.

Les plateformes de sauvegarde dédiées aux VM capturent uniquement les métadonnées nécessaires, facilitant une restauration granulée allant jusqu’au fichier unique. Ce mode de sauvegarde optimise les performances et réduit les fenêtres d’indisponibilité, un élément fondamental pour les services critiques.

Le choix d’une solution qui prend en charge la restauration granulaire est stratégique pour maintenir l’agilité et maîtriser les coûts associés à la protection des données.

Vers un avenir virtualisé : nouvelles architectures et enjeux

La virtualisation s’inscrit dans une mutation plus large des infrastructures : sécurité dématérialisée, réseaux définis par logiciel (SD-WAN), stockage avancé comme les NAS et SAN se combinent pour former des systèmes plus souples et adaptatifs. Cette évolution ouvre la voie à des architectures hybrides et multi-cloud, où la gestion des VM trône au cœur des opérations.

Sur le plan éthique et social, cette complexification pose des questions sur la souveraineté des données, la transparence des algorithmes d’allocation des ressources, et l’empreinte énergétique. Mieux allouer ne suffit pas, il faut aussi mesurer et comprendre les impacts environnementaux, humains, et légaux.

L’enjeu reste d’accompagner ces transformations avec des outils intuitifs et des protocoles robustes pour garantir que la virtualisation serve réellement l’innovation, la résilience, et la responsabilité.

Plus que jamais, la gestion sophistiquée et vigilante des infrastructures virtualisées marque une étape déterminante pour les entreprises qui veulent garder le contrôle tout en gagnant en souplesse.

Pour approfondir les mécanismes d’authentification complexes utilisés dans certains environnements sécurisés, un détour par le principes de Kerberos est toujours instructif.

Enfin, une bonne maîtrise technique suppose aussi une compréhension claire des diverses modalités de stockage virtualisé, qu’elles soient sous forme de NAS ou de SAN, adaptés à des usages domestiques ou professionnels (détails ici).

Avec la virtualisation, on ne fait pas que redistribuer les ressources. On redéfinit aussi la manière dont on conçoit et organise l’informatique.

Si une phrase semble trop parfaite, casse-la.

Si le ton devient trop lisse, rends-le plus humain.

Écris comme si tu parlais à voix basse à quelqu’un d’intelligent.

Passionné par les nouvelles technologies depuis plus de 20 ans, j’exerce en tant qu’expert tech avec une spécialisation en développement et innovation. Toujours à la recherche de solutions performantes, je mets mon expérience au service de projets ambitieux.